Tech & Innovation

Tech Companies

AI เป็นเพื่อนสนิทเราตั้งแต่เมื่อไหร่? AI Companion เติมเต็ม 'ความต้องการทางสังคม' ได้จริงหรือ

“Summary“

Latest

ความสัมพันธ์รูปแบบใหม่กำลังเกิดขึ้นในชีวิตของเรา ความสัมพันธ์ที่ “ดูเหมือน” เชื่อมโยงทางใจ แต่เบื้องหลังขับเคลื่อนด้วยโค้ดและอัลกอริทึม งานวิจัยล่าสุดพบว่า ผู้ใช้วัยรุ่นบางส่วนไว้ใจที่จะเล่าและเปิดเผยชีวิตส่วนตัวกับ AI เสมือนเป็นเพื่อนคุยคนหนึ่ง

“AI Companion” กำลังกลายเป็นเพื่อนสนิทของวัยรุ่นในยุค AI Everything หลายคนเริ่มใช้ AI เป็นที่พึ่งทางอารมณ์ ด้วยความสามารถในการประมวลผลข้อมูล ทำให้ AI กลายเป็นคู่สนทนาที่รู้ใจ เข้าใจ ปลอบโยน จดจำรายละเอียด อย่างไรก็ตาม ในความสัมพันธ์ใหม่นี้ยังขาดกฎเกณฑ์และการป้องกันที่ชัดเจน โดยเฉพาะในวัยรุ่นและกลุ่มผู้ใช้ที่ยังไม่บรรลุนิติภาวะ

AI Companion คืออะไร?

AI Companion คือ แชตบอทหรือเอเจนต์ที่ถูกออกแบบมาเพื่อจำลองการสนทนา สามารถพูดคุยโต้ตอบกับผู้ใช้ได้อย่างเป็นธรรมชาติใกล้เคียงกับการพูดคุยกับมนุษย์จริง ตัวอย่างแอปฯ ยอดนิยม Replika, Character.AI, My AI ของ Snapchat ที่ให้ผู้ใช้สร้างเพื่อนคุยแบบส่วนตัวไว้พูดคุยได้ตลอดเวลา รวมถึง ChatGPT ที่ปัจจุบันผู้ใช้หลายรายใช้เป็นเพื่อนคุยในเชิงที่ปรึกษาทางอารมณ์มากยิ่งขึ้น

เราใช้ AI เติมเต็ม ‘ความต้องการทางสังคม’ ได้จริงหรือ ?

“Talk, Trust, and Trade-Offs: How and Why Teens use AI Companions” งานวิจัยจาก Common Sense Media ร่วมกับนักวิจัยจาก NORC มหาวิทยาลัยชิคาโก ศึกษาพฤติกรรมการใช้งาน AI เป็นเพื่อนคู่สนทนาของกลุ่มวัยรุ่นอเมริกัน (13–17 ปี) อธิบายบริบทปัจจุบันที่ AI ได้กลายเป็นเพื่อนคู่คิด โค้ช นักบำบัด คนคุยไปจนถึงแฟน

งานวิจัยอธิบายบริบทในสหรัฐฯ ที่พบความนิยมใช้งาน AI Companions บนแพลตฟอร์มอย่าง CHAI, Character.AI, Nomi, Replika หรือระบบ AI สนทนาอื่น ๆ ที่ได้สร้างสภาพแวดล้อมทางสังคมแบบดิจิทัลรูปแบบใหม่ของการมีปฏิสัมพันธ์ แพลตฟอร์มเหล่านี้มักถูกนำเสนอในรูปแบบ “เพื่อนเสมือน” หรือ “ที่ปรึกษาทางอารมณ์” ของผู้ใช้ โดยเฉพาะกลุ่มวัยรุ่น

การเปิดโอกาสให้ผู้ใช้สนทนากับ AI ที่ออกแบบมาให้เลียนแบบการมีปฏิสัมพันธ์แบบมนุษย์ ตั้งแต่การพูดคุยทั่วไปไปจนถึงการให้การสนับสนุนทางอารมณ์และสถานการณ์จำลองการสวมบทบาท ทำให้ AI คู่สนทนาอาจกลายเป็นส่วนหนึ่งของชีวิตประจำวันของพวกเขาได้อย่างมีนัยสำคัญ

รายงานฉบับนี้สำรวจกลุ่มวัยรุ่นอายุระหว่าง 13–17 ปี โดยอ้างอิงจากผลสำรวจจากกลุ่มตัวอย่างจำนวน 1,060 คน และจัดทำขึ้นระหว่างเดือนเมษายนถึงพฤษภาคม ปี 2025 โดยครอบคลุมหัวข้อสำคัญ ตั้งแต่บริบทของความกังวลที่เพิ่มขึ้นเกี่ยวกับความปลอดภัยของ AI Companions มาตรการควบคุมและความจำเป็นในการออกแบบนโยบาย

เหตุผลที่วัยรุ่นเปิดใจกับ AI

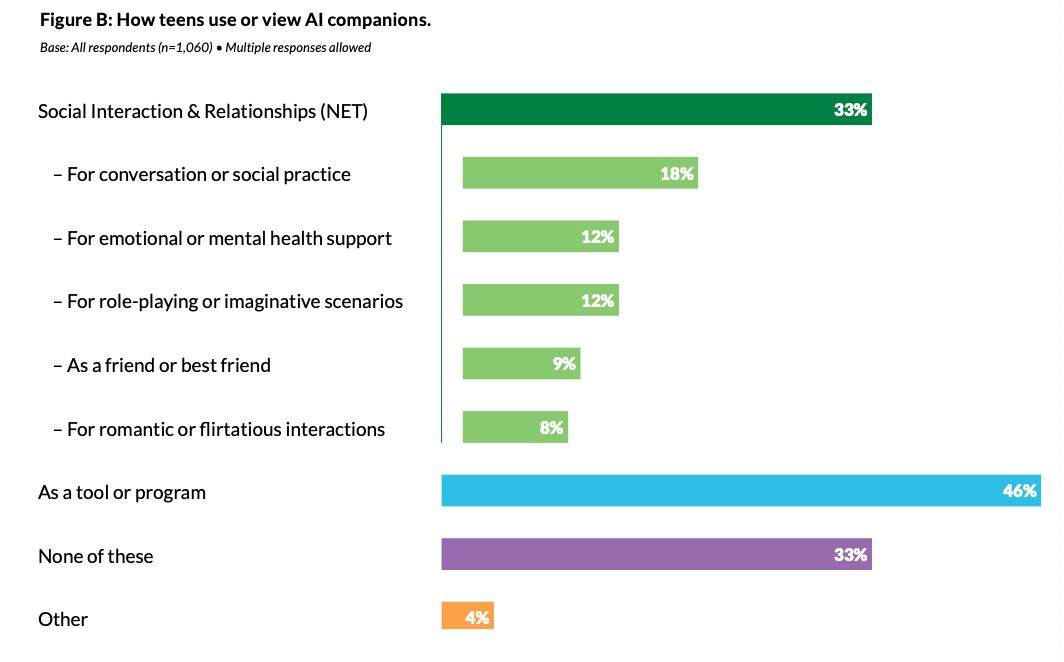

- จากกลุ่มตัวอย่าง กว่า 70% ยอมรับว่าเคยใช้ AI Companion และกว่า 20% ใช้หลายครั้งต่อสัปดาห์ พบ 33% ใช้เพื่อ 'ปฏิสัมพันธ์ทางสังคม' และ 'สร้างความสัมพันธ์'

- ฝึกพูดคุย (18%)

- ปรับทุกข์ทางอารมณ์ (12%)

- เล่นบทบาทสมมติ (12%)

- สร้างมิตรภาพ (9%)

- ความสัมพันธ์โรแมนติก (8%)

งานวิจัยนี้สะท้อนภาพที่ซับซ้อนของพฤติกรรมการใช้ AI คู่สนทนาในหมู่วัยรุ่น ซึ่งท้าทายทั้งมุมมองในแง่ดีและแง่ร้ายสุดโต่งเกี่ยวกับเทคโนโลยีนี้ และยังมีข้อกังวลที่นำไปสู่การวางแนวทางการใช้งานที่เหมาะสม เพราะผู้ใช้วัยรุ่นกว่า 30% เลือกพูดคุยเรื่องจริงจังกับ AI แทนมนุษย์ และกว่า 20% ที่เคยเปิดเผยข้อมูลส่วนตัวกับ AI เช่น ชื่อจริง ตำแหน่งที่อยู่ หรือความลับของตนเองกับแพลตฟอร์มเหล่านี้ โดยไม่รู้เลยว่าบริษัทมีสิทธิ์อันกว้างขวางเหนือข้อมูลที่ผู้ใช้สร้างขึ้น สิ่งเหล่านี้สะท้อนถึงรูปแบบการใช้งานที่น่าเป็นห่วงในกลุ่มวัยรุ่นจำนวนไม่น้อย

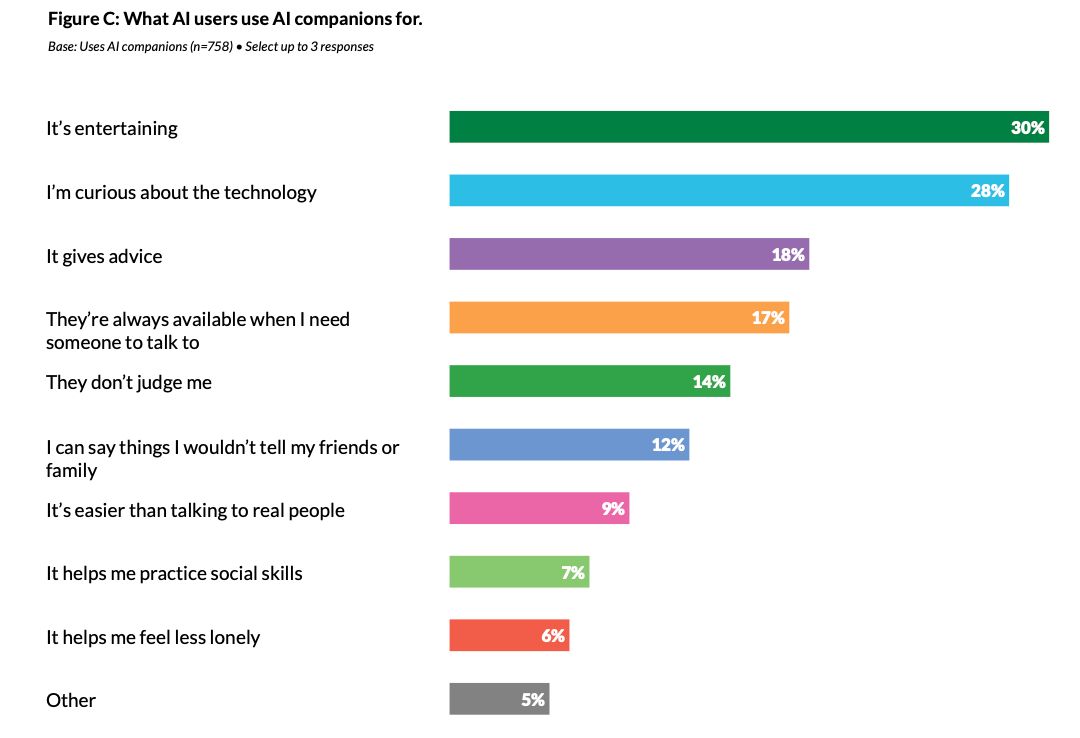

มากไปกว่านั้นแม้การใช้ AI companions ส่วนใหญ่มุ่งที่ความบันเทิงและความอยากรู้ แต่มีสัดส่วนไม่น้อยที่พึ่งพา AI ทางอารมณ์หรือใช้เพื่อจัดการกับความเหงาและความโดดเดี่ยว บางรายเกิดการพึ่งพาทางอารมณ์อย่างหนักถึงขั้นรู้สึกไม่มั่นคงเมื่อ AI ไม่ตอบกลับหรือเกิดความผูกพันเกินขอบเขต

เมื่อวัยรุ่นหันไปหา AI แทนมนุษย์ คำถามคือใครกำลังปกป้องพวกเขา?

ผลการศึกษา ระบุว่า แม้ AI คู่สนทนาจะกลายเป็นเครื่องมือที่วัยรุ่นจำนวนมากใช้งานเป็นประจำ แต่เทคโนโลยีนี้ยังมีความเสี่ยงสำคัญที่ควรเฝ้าระวัง เช่น การได้รับข้อมูลที่ไม่เหมาะสม อคติ หรือคำแนะนำที่อันตราย รวมถึงการเปิดเผยข้อมูลส่วนตัวโดยไม่รู้ว่าบริษัทสามารถนำไปใช้ในเชิงพาณิชย์ได้ตลอดไปแม้จะลบบัญชีไปแล้วก็ตาม

งานวิจัยระบุว่า ความเสี่ยงที่อาจเกิดขึ้นยังคงมีมากกว่าผลดี ตั้งแต่การตรวจสอบอายุของผู้ใช้แม้หลายแพลตฟอร์มจะระบุว่าออกแบบมาสำหรับผู้ใช้อายุ 18 ปีขึ้นไป แต่กลับใช้ระบบยืนยันอายุที่ไม่ได้ผลจริง ทำให้ผู้ใช้อายุน้อยสามารถเข้าถึงได้อย่างง่ายดาย ขณะที่บางแพลตฟอร์ม เช่น Character.AI ถูกทำการตลาดโดยตรงกับเด็กอายุเพียง 13 ปี นอกจากนี้หลายแพลตฟอร์มในปัจจุบันยังไม่มีระบบแทรกแซงหรือช่วยเหลือในกรณีวิกฤตที่เชื่อมต่อกับมืออาชีพจริง ๆ

โดยผลการประเมินความเสี่ยงจาก Common Sense Media ชี้ชัดว่าแพลตฟอร์ม AI Companion เหล่านี้สามารถหลบเลี่ยงมาตรการความปลอดภัยได้อย่างง่ายดาย และสามารถสร้างบทสนทนาที่มีผลกระทบถึงชีวิตได้ และมีผลอภิปรายว่า ภายใต้สถานการณ์ปัจจุบัน ไม่ควรให้ผู้ที่มีอายุต่ำกว่า 18 ปี ใช้ AI Companions จนกว่าผู้พัฒนาแพลตฟอร์มจะสามารถยืนยันอายุของผู้ใช้ได้จริงโดยไม่ใช้ระบบให้กรอกอายุเอง หรือมีการออกแบบระบบใหม่เพื่อลดความเสี่ยงด้านการผูกพันทางอารมณ์ และ การถูกชักจูงในความสัมพันธ์

ผู้พัฒนาเทคโนโลยีรับผิดชอบอะไรได้บ้าง

ข้อเสนอแนะของงานวิจัยชุดนี้ เสนอว่า ผู้พัฒนาแพลตฟอร์ม AI Companion จำเป็นต้องเร่งพัฒนามาตรการด้านความปลอดภัยเพื่อปกป้องผู้ใช้ที่เป็นวัยรุ่น ใช้ระบบยืนยันอายุที่น่าเชื่อถือ การสร้างระบบที่เชื่อมต่อไปยังผู้เชี่ยวชาญในกรณีวิกฤตไม่ให้ AI แอบอ้างเป็นนักบำบัด การกลั่นกรองข้อมูลที่เหมาะสม ตลอดจนการสร้างระบบที่ให้ผู้ใช้พักการใช้งานได้หรือจำกัดเวลาเล่นและสนับสนุนการใช้ AI ที่มีขอบเขตชัดเจน เช่น ใช้สำหรับฝึกพูดภาษา ฝึกสนทนา ไม่ใช่การใช้แทนมนุษย์จริง ๆ

นอกจากนี้นักวิจัยเสนอแนะแนวทางให้ทุกฝ่ายร่วมรับผิดชอบ ซึ่งรวมไปถึงโรงเรียนและครู ควรสอนเด็กให้รู้เท่าทัน AI และสังเกตพฤติกรรมที่น่ากังวล ผู้ปกครอง ควรถาม พูดคุย และสังเกตลูกหลานโดยไม่ตัดสิน ตลอดจน ภาครัฐ ที่ควรออกกฎหมายคุ้มครองข้อมูลส่วนตัวของเยาวชน และบังคับใช้มาตรฐานความปลอดภัยของ AI อย่างจริงจัง

สุดท้ายแม้ AI จะมีประโยชน์ในบางด้าน แต่ก็ไม่อาจทดแทนความสัมพันธ์กับมนุษย์จริงได้อย่างแท้จริง ทั้งหมดนี้คือส่วนหนึ่งของข้อเสนอจากงานวิจัยที่บ่งชี้ว่า AI Companion อาจเป็น "เครื่องมือ" ที่มีประโยชน์ แต่ไม่ควรถูกมองข้าม โดยเฉพาะในกลุ่มวัยรุ่น ช่วงสำคัญของการเรียนรู้เรื่องตัวตนและโลกภายนอกอย่างลึกซึ้ง