Tech & Innovation

Tech Companies

เก่งกว่าเดิม OpenAI เปิดตัว GPT-4 ปัญญาประดิษฐ์เวอร์ชั่นใหม่ ตอบมั่วน้อยลง หลังทำงานกับคนมากขึ้น

“Summary“

OpenAI เปิดตัว GPT-4 โมเดล AI ตัวล่าสุด ที่ปรับปรุงประสิทธิภาพการวิเคราะห์ประมวลผลจาก GPT-3 โดยตอนนี้อยู่ในช่วงเปิดให้ทดลองใช้เดโมแบบจำกัดใน ChatGPT Plus สำหรับผู้ที่สมัครสมาชิกพรีเมียม และใน Discord พร้อมเปิดให้นักพัฒนาลงชื่อรอเพื่อใช้งาน API

GPT-4 ฉลาดขึ้นอย่างไร

เดิมที GPT3 จะสร้างชุดคำตอบในรูปแบบข้อความที่มีความสละสลวยผ่านการกลั่นกรองข้อมูลตามคำสั่ง ทั้งภาษามนุษย์และภาษาโค้ดในรูปแบบต่างๆ เช่น ตอบบทความ ตอบเป็นข้อ ตอบเป็นตารางแจกแจงข้อมูล

ความสามารถของ GPT-4 จะสร้างชุดคำตอบที่เป็นข้อความเหมือนเดิม แต่ตอบคำถามได้มีประสิทธิภาพมากขึ้น โดยเฉพาะเรื่องที่ซับซ้อน ลักษณะคำตอบมีความละเอียด มีเหตุมีผลและสร้างสรรค์มากขึ้น สามารถคาดการณ์บริบทของคำตอบที่มีความเกี่ยวโยงต่อเนื่อง

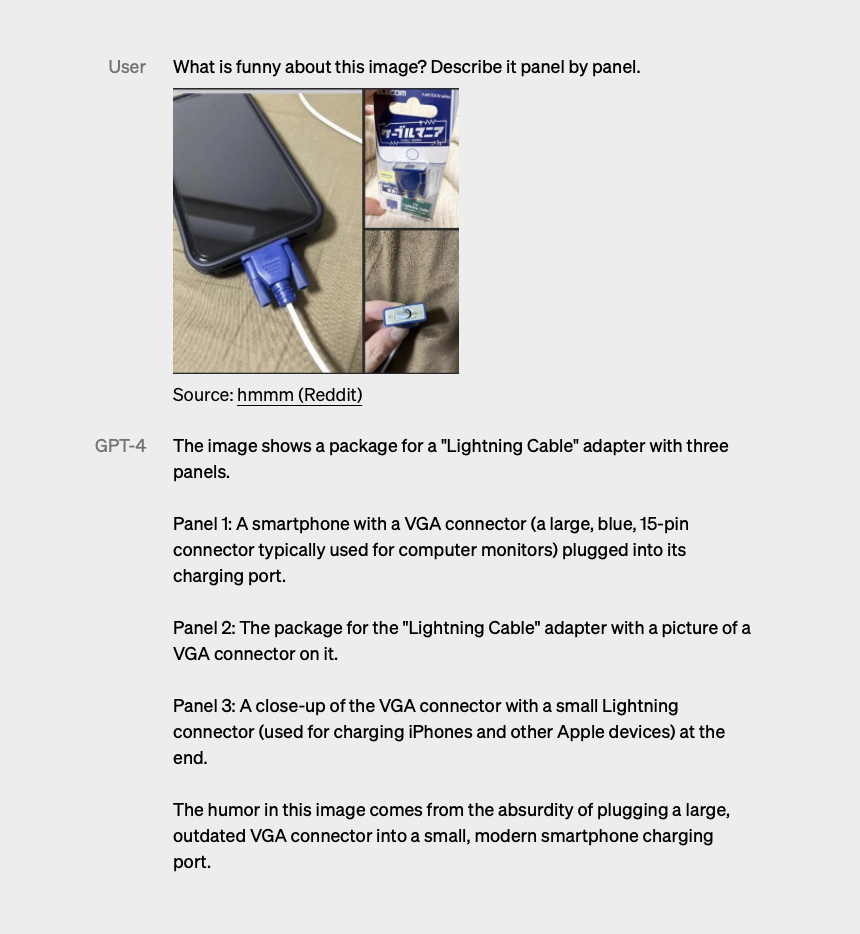

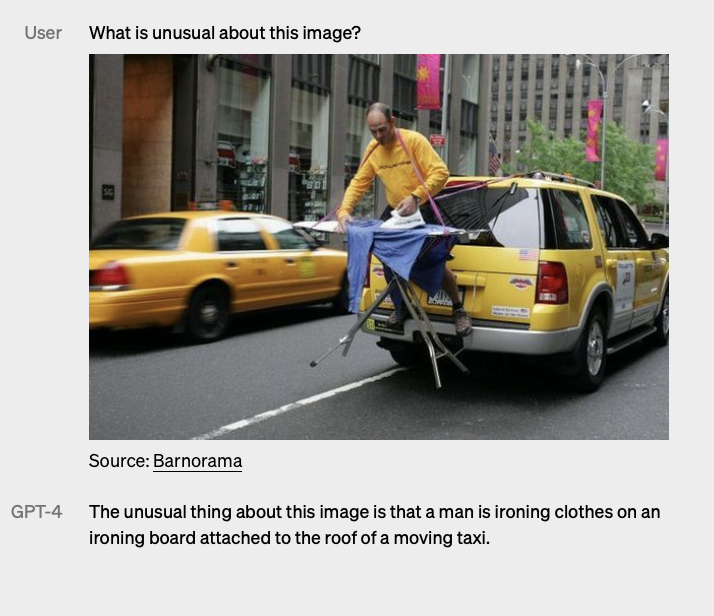

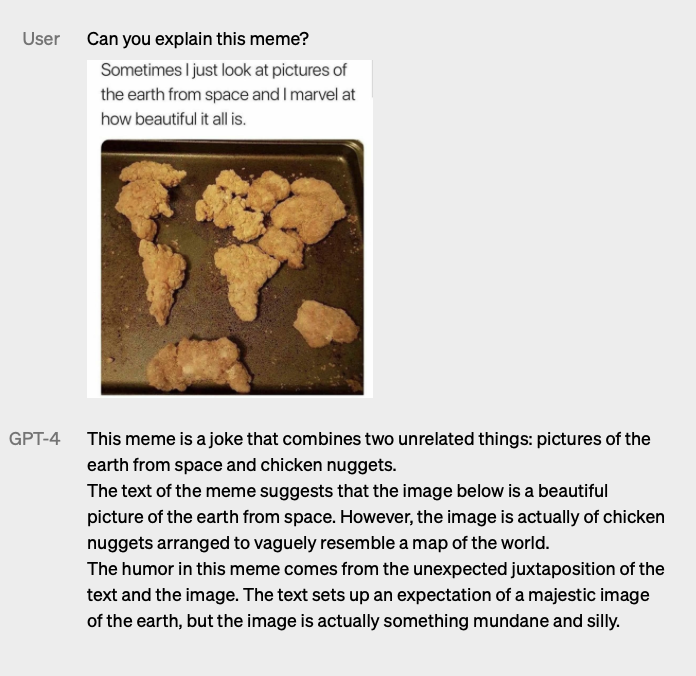

โดยสิ่งที่เพิ่มเติมจากเดิม คือ ความสามารถในการอ่านภาพ แยกแยะองค์ประกอบภาพ อธิบายบริบทภาพที่เห็น หาความผิดปกติในภาพ อ่าน สกัดข้อมูลจากภาพและวิเคราะห์ข้อมูลต่อ จากนั้นสามารถสร้างชุดคำตอบตามคำสั่ง พร้อมบอกข้อมูลบริบทที่ต่อเนื่องจากภาพที่เห็น

เช่น คิดโจทย์เลขจากภาพสมการในหน้าข้อสอบ อธิบายลำดับช่วงเวลาจากภาพไทม์ไลน์ การสรุปเนื้อหาจากงานวิจัยที่มีทั้งข้อความและแผนภูมิข้อมูล การแยกแยะอารมณ์ขันกับข้อมูลจากภาพมีม เป็นต้น นอกจากนี้ยังสามารถสร้างชุดคำตอบที่เป็นโค้ดดิ้งจากภาพ (Image-to-code) แปลรูปภาพเป็น HTML และ JavaScript ได้อีกด้วย

สิ่งที่แตกต่างจาก GPT-3

ปริมาณข้อมูล (Features)

GPT-4 ยังมีฟีดเจอร์ชุดข้อมูลที่อัพเดทถึงปี 2021 ที่เทรนด์มาแล้วเป็นระยะเวลา 2 ปีเหมือน GPT-3.5 แต่อ่านโทเค็นได้มากขึ้นต่อเนื่องกว่า 32,000 โทเค็น (หน่วยย่อยฟีดเจอร์)

การรับคำสั่ง (Prompt)

GPT-3 รับคำสั่งที่เป็นข้อความเพียงอย่างเดียว GPT-4 รับคำสั่งทั้ง ‘ข้อความและรูปภาพ’

ระบบปฏิบัติการ (Flow of Learning Model)

GPT-4 เป็น Large Scale Multimodal Model ที่รับคำสั่งได้ทั้งข้อความและรูปภาพพร้อมกัน (Text-Visual Inputs) มีพื้นฐานการประมวลภาพของ Computer Vision และเทรนด์ด้วยโมเดลการประมวลภาษาขั้นสูง Pre-trained Model และ Transformers Model และการเทรนด์นิ่งโดยมนุษย์หรือ Reinforment Learning from Human Feedback (RLHF) ที่เข้มข้นมากขึ้น

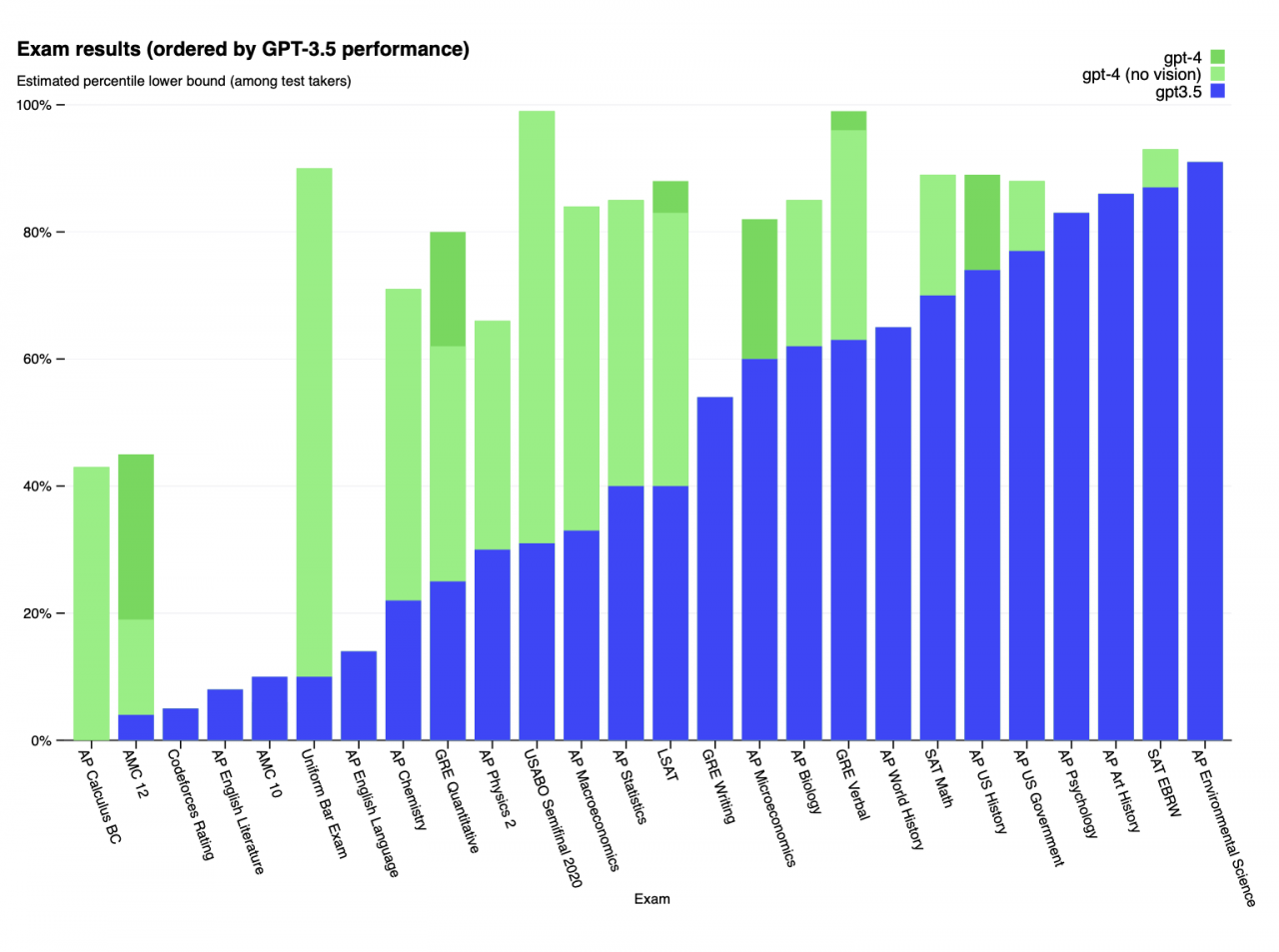

สำหรับการประเมินศักยภาพมีการให้ GPT-4 ทำแบบทดสอบต่างๆ เช่น LSAT, SAT Math และ SAT Evidence-Based Reading & Writing โดย GPT-4 สามารถทำคะแนนได้มากกว่า 80 คะแนนเกือบทุกวิชา ทำได้ดีกว่า GPT-3 แถมยังทำข้อสอบได้ถูกต้องกว่ามนุษย์ที่เข้าทดสอบ การวัดประสิทธิภาพตาม NLP Benchmark GPT-4 มีประสิทธิภาพดีที่สุดกว่าโมเดลประมวลภาษาที่เคยมีมา มีความเข้าใจภาษาอื่นๆ นอกเหนือจากภาษาอังกฤษในระดับที่ดียิ่งขึ้น คลิกอ่าน Technical Report เพิ่มเติม

อย่างไรก็ตาม หากกล่าวถึงข้อจำกัด GPT-4 ยังมีข้อจำกัดที่คล้ายคลึงกันกับ GPT รุ่นก่อนหน้า กล่าวคือ ยังคงตอบคำถามที่ผิดได้อย่างมั่นใจเหมือนเดิม ถึงแม้จะสร้างข้อความที่แม่นยำมากขึ้นแต่ไม่ได้แปลว่าผลลัพธ์ที่ได้จะถูกต้องหรือน่าเชื่อถืออย่างสมบูรณ์นั่นเอง

การเปิดตัวครั้งนี้ OpenAI เปิดเผยว่าได้ทดลองใช้ในบริษัทเพื่อให้ช่วยงานด้านการขาย การบริหารจัดคอนเทนต์ การเขียนโปรแกรม การวิเคราะห์ประเมิน AI ด้วยกันเอง โดยมีพันธมิตรธุรกิจที่นำ GPT-4 ไปใช้แล้ว เช่น Stripe, Duolingo, Morgan Stanley และ Microsoft ที่นำไปใช้ใน Bing เวอร์ชั่นใหม่ที่เปิดตัวไปล่าสุด

นอกจากนี้ยังเปิดตัวนโยบาย 'OpenAI Evals' เฟรมเวิร์คโอเพ่นซอร์ส ที่เปิดให้นักพัฒนาทั่วไปเข้ามาตรวจสอบโค้ดและประเมินโมเดลร่วมกันเพื่อสร้างกฎเกณฑ์การพัฒนา AI ที่มีความถูกต้องและความปลอดภัย เปิดให้มีส่วนร่วมในการปรับปรุงของ GPT-4 ซึ่งจะเป็นประโยชน์ต่อฐานผู้ใช้ที่กว้างขึ้น

อ้างอิง OpenAI